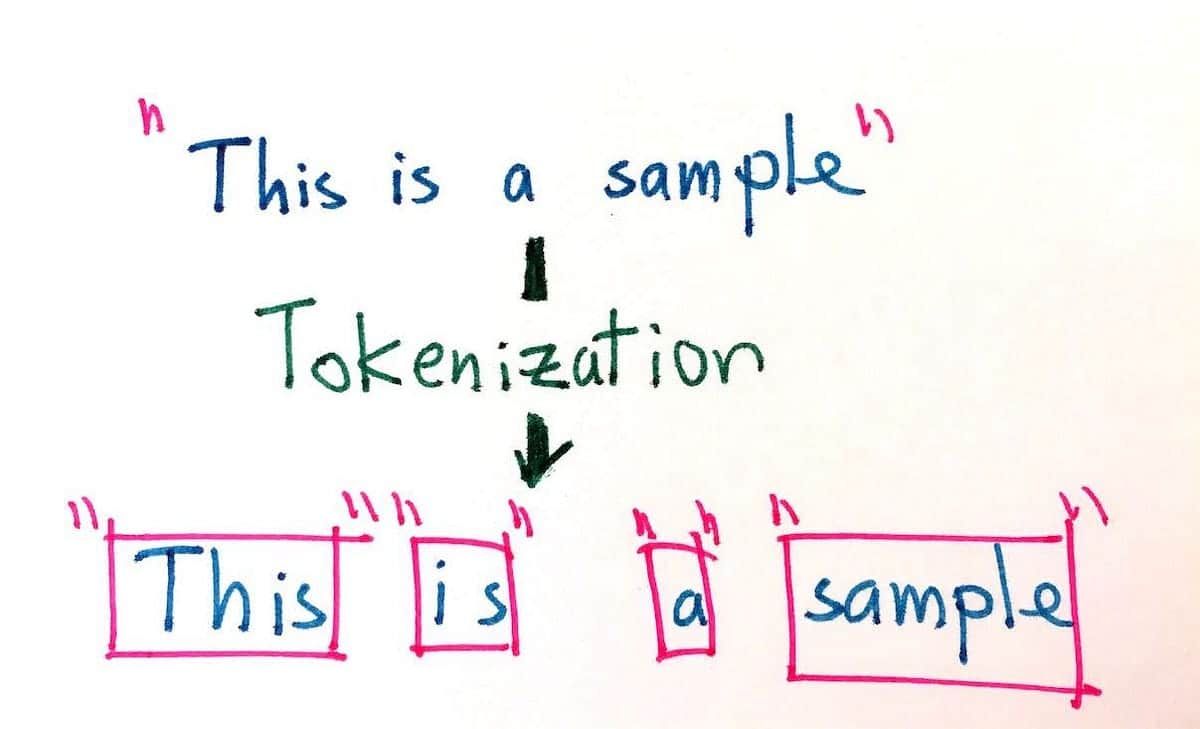

Tokenizasyon, doğal dil işleme (NLP) süreçlerinde kritik bir adımdır. Ancak, Türkçe, Macarca ve Fince gibi diller için geleneksel yaklaşımlar yetersiz kalıyor. Yıldız Teknik Üniversitesi, Yeditepe Üniversitesi, Chicago Üniversitesi ve İstanbul Bilgi Üniversitesi araştırmacıları, bu diller için daha etkili bir tokenizasyon yöntemi geliştirmek amacıyla yeni bir değerlendirme çerçevesi önerdi.

Massive Multitask Language Understanding (MMLU) benchmark’ından alınan 6,200 soruluk veri kümesi ile yapılan bu çalışma, beş temel metrik kullanarak tokenizasyon kalitesini değerlendiriyor:

✅ Kelime dağarcığı büyüklüğü

✅ Toplam token sayısı

✅ İşleme süresi

✅ Türkçe’ye özgü token yüzdesi (%TR)

✅ Token saflığı (%Pure)

%TR, üretilen tokenlerin gerçek kelimelere ne kadar yakın olduğunu ölçerken, %Pure, kelimelerin anlamsal bütünlüğünü değerlendiriyor. Çalışmanın bulgularına göre, %TR modeli doğruluğuyla daha güçlü bir ilişki gösteriyor ve daha büyük modellerin her zaman daha iyi tokenizasyon yapmadığını kanıtlıyor.

Bu araştırma, NLP için yeni bir standart oluşturuyor ve karmaşık diller için yapay zeka modellerini daha verimli hale getirmeyi amaçlıyor. Gelecek çalışmalar, morfolojik analizlerin geliştirilmesine ve farklı dillerde çapraz değerlendirmeler yapılmasına odaklanacak.

Kaynak : https://arxiv.org/abs/2502.07057